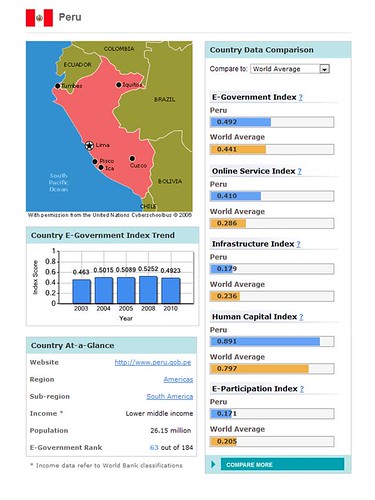

Este 4 de noviembre el Partido Aprista presentó una iniciativa legislativa (04434/2010-CR) que pretende declarar como derecho fundamental el acceso a la banda ancha para todo ciudadano peruano residente en el territorio nacional. Dedicaremos esta entrada a comentar la norma y sus posibles efectos.

En principio, toda preocupación para masificar el acceso a Internet a través de conexiones de banda ancha debe ser aplaudida, sin embargo, creemos que los efectos de esta norma, en el improbable caso que sea aprobada, serán más bien escasos por no decir irrelevantes.

Que la mayoría de ciudadanos en distintas latitudes consideran que el acceso a Internet es un derecho fundamental es una realidad incontrastable. En un estudio (BBC: Internet es un derecho fundamental) realizado por Globescan entre noviembre de 2009 y febrero de 2010 para el Servicio Mundial de la BBC, reveló que el 79 por ciento de los encuestados consideraban que el acceso a Internet era efectivamente un derecho fundamental. Como era de esperarse siete de cada diez personas que carecían de Internet consideraron que deberían tener derecho al acceso a la Red. El número de encuestados, 27 mil adultos de 26 países. Los países latinoamericanos donde se llevó a cabo la encuesta fueron Brasil, Chile, Costa Rica, El Salvador, Guatemala, Honduras, México, Nicaragua y Panamá.

Sin embargo, tengo serias dudas de que el acceso a la banda ancha pueda considerarse como un derecho fundamental; y; por otro lado, estimo que no es con esta declaración como las naciones han logrado su masificación.

La iniciativa parlamentaria señala como antecedentes que diversos Estados ya habrían declarado el acceso a la banda ancha como un Derecho, refiriéndose puntualmente a los casos de Finlandia, Costa Rica, España, Grecia y Francia. Está bien si se quiere ostentar el prurito de ser pioneros en incorporar el acceso a la banda ancha como un derecho como fundamental, sin embargo, no es correcto decir que los países mencionados han elevado el acceso a la banda ancha como un derecho fundamental. Vayamos por partes.

España no reconoce el acceso a la banda ancha como un derecho fundamental. Lo que existe es un proceso de consulta en marcha para incorporar a la banda ancha dentro del paquete del servicio universal (aquí). El caso de Grecia pareciera ser similar al español -la banda ancha dentro de las obligaciones del servicio universal-, aunque no he podido encontrar una referencia seria sobre el particular.

Aun cuando Suiza no está en la lista de países pioneros en reconocer este derecho que nos presenta el Proyecto, suele citarse como ejemplo de declaración del acceso a la banda ancha como derecho fundamental. Sin embargo, esta referencia no es correcta. En el año 2006 el regulador suizo de las telecomunicaciones (Federal Office of Communications) ajustó (aquí) las obligaciones del servicio universal e incluyó como parte de la oferta de servicios indispensables a aplicarse desde el 2008, un acceso a Internet a una velocidad de transmisión mínima de 600/100 kbps.

Tampoco Costa Rica ha declarado el acceso a la banda ancha como derecho fundamental como parece señalarse en el Proyecto. Lo que existe es un fallo de la Sala Constitucional (aquí) en el marco de un recurso de amparo interpuesto contra el Ministerio de Ambiente, Energía y Telecomunicaciones para que asumiera sus obligaciones en el marco del Tratado de Libre Comercio entre la República Dominicana, Centro América y Estados Unidos (CAFTA), en particular que se acelerara el proceso de subasta y asignación de determinadas frecuencias para telefonía celular. La Sala, no considera el acceso a Internet como un derecho fundamental, advierte que en los actuales momentos «(…) el acceso a estas tecnologías se convierte en un instrumento básico para facilitar el ejercicio de derechos fundamentales«. En lo que importa, la Sala ordenó que se procediera al concurso de las licencias.

El caso de Francia es similar, una sentencia judicial del Consejo Constitucional (Conseil constitutionnel) dispuso, al examinar la constitucionalidad de la conocida ley Hadopi, que Internet es una herramienta indispensable para el ejercicio de la libertad de expresión, consagrado como un derecho fundamental y por ello su acceso debe ser garantizado plenamente. Por tanto, de acuerdo con el Consejo, corresponde a un juez, y no a una autoridad administrativa, decidir si procede aplicar determinada sanción por descargas ilegales de contenidos por Internet.

El caso de Finlandia fue muy sonado y se presentó como el primer país que reconocía el acceso a Internet a través de la banda ancha como un derecho fundamental (Applause For Finland: First Country To Make Broadband Access A Legal Right). Tampoco la información es correcta. En diciembre de 2008, el Gobierno finlandés aprobó el Plan Nacional de Banda Ancha para el período 2009-2015. El Plan, incorporó a las conexiones de 1 Mbps como parte del servicio universal para el año 2010 (aquí). En mayo de 2009 se modificó la Ley del Mercado de Comunicaciones (393/2003) para permitir que la regulación de la velocidad mínima de conexión a Internet por el Ministerio de Transportes y Comunicaciones (Liikenne- ja viestintäministeriö). En octubre de 2009 el Ministerio de Transportes y Comunicaciones emitió un Decreto relativo a la velocidad mínima de conexión a Internet. Según este Decreto, la velocidad de conexión mínima para el tráfico de entrada debía ser de 1 Mbps. para todo ciudadano residente en Finlandia (aquí y aquí). Es decir, las autoridades finesas han ajustado las obligaciones del servicio universal incorporando un mínimo de velocidad para el tráfico de Internet, lo que en sentido estricto no es reconocer al acceso a Internet como un derecho fundamental.

Como hemos visto, ninguno de los países citados por el Proyecto han elevado el acceso a Internet al nivel de derecho fundamental. En los ejemplos español, griego y finlandés nos encontramos ante un afinamiento de las políticas del servicio universal y en los casos francés y costarricense tenemos una declaración en el marco de sendas sentencias judiciales.

De aprobarse el Proyecto bajo comentario el Perú sería el primer país del mundo en reconocer el acceso a Internet, a la banda ancha en particular, como un derecho fundamental. En una siguiente entrada seguiremos comentando sobre el particular.