En 1999 el número de usuarios de Internet apenas superaba los 50 millones, hoy tiene más de mil millones. Es decir, si hace diez años sólo el 1,1 por ciento de los habitantes del planeta estaba conectado a la Red hoy esa cifra se ha incrementado hasta alcanzar un nada despreciable índice de 14,7 por ciento.

No vale la pena hacer un recuento de cómo era la Red hace dos lustros para comparar cómo es ahora. La mayoría de las personas, sobre la base de su propia experiencia, sabe cuales son las diferencias entre el Internet del año 1999 y el del 2009. Los contrastes son incluso mayores que la distancia fría entre el número de usuarios conectados hoy y el de hace diez años.

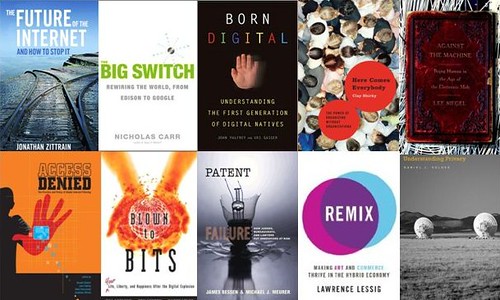

Es por ello la importancia del décimo aniversario de la edición en inglés del ya clásico e influyente libro de Lawrence Lessig, Code and Other Laws of Cyberspace (existe edición en español, El código y otras leyes del ciberespacio, Taurus, 2001). Si bien, cualquier reseña que se haga de este trabajo no puede dejar de advertir la obviedad de que Internet ya no es lo que era, tampoco dejará de destacar que, pese a ello, El Código sigue teniendo una enorme vigencia, lo cual es un mérito innegable de Lessig. Cuando esto ocurre en uno de los campos más dinámicos del mundo moderno, sólo puede deberse a dos situaciones: que nos encontramos ante un libro adelantado a su tiempo o porque está plagado de dogmática e ideología. La entrega de Lessig tiene las dos cosas.

Es cierto que los acontecimientos ocurridos desde la publicación del libro han hecho que se haya desfasado, sin embargo, ello no invalida en esencia la tesis de Lessig, por el contrario el tiempo pareciera haberle dado la razón. Situándonos en contexto, El Código pretendía cuestionar una serie de nociones profundamente enraizadas a fines del siglo pasado. Estas ideas, que podríamos llamar utópicas, nos decían que la Red se mantendría lejos de las garras del gobierno y de sus mecanismos de control tradicionales. Lessig trajo malas noticias, previó la posibilidad de un Internet controlado a partir de tecnologías para estimular el comercio apoyadas por la ley tradicional.

Para Lessig, Internet en sus orígenes no era un entorno inherentemente libre. Aunque era un espacio donde la ley estatal encontraba muchas dificultades para imponerse, esta situación, gracias a la arquitectura de la Red (código), era coyuntural. Un nuevo código podía hacer que Internet fuera permeable no sólo a la regulación estatal sino a algunos intereses privados lejos de los controles de la sociedad democrática.

Para evitar esta situación, Lessig proponía el diseño de una arquitectura que limitara el poder que pudieran ejercer los gobiernos y las empresas, y por lo tanto, que garantizara algunos derechos básicos, como la libertad de expresión o la privacidad. Este es el punto clave del libro, la diferencia entre el software propietario y el libre. Si el código está en manos de unas pocas personas, puede ser desarrollado de una forma tal que se asegure el control sobre sus usos, sin que sea posible poner límites a ese control. Por el contrario, si el código no es propiedad de nadie o lo es de muchos, se produce una suerte de propiedad comunal, donde se respeten los derechos fundamentales y es tierra fértil para la innovación.

Pero esta historia no termina aquí, existe nueva versión del libro, la cual como se señala en su Prefacio: «es una revisión de un libro viejo, de hecho, en Internet, es una revisión de un texto antiguo«. Nos referimos al Code version 2.0, escrito a partir de una Wiki alimentada por aquellos interados en participar. Puede descargarse en formato PDF y también puede comprarse en Amazon y Barnes&Noble. Esto último, según eadvierte el autor en su blog, es «una sabia elección, ya que es más barata que la impresión del libro en la mayoría de los contextos».