En agosto de 2008, la Comisión hizo público su Memorandum Opinion and Order (.pdf) en el caso Comcast. La cuestión era si el bloqueo del tráfico peer-to-peer (p2p) constituía una práctica razonable de gestión de red por parte de Comcast. Si bien la FCC contaba con las reglas de la Net Neutrality enunciadas a manera de principios, no eran parte de ninguna regulación de fuente legal. En este caso, la Comisión afrontó el problema de bajo qué norma analizar y sancionar la conducta de Comcast. La decisión final fue ordenar a Comcast detener dicha práctica y ordenarle transparentar sus medidas de gestión de red, sin sancionarla. Contó con tres votos a favor, incluyendo el del presidente Kevin Martin, y dos en contra (3-2).

Los argumentos de la FCC

Como habíamos señalado, la provisión de acceso a Internet de banda ancha por parte de las empresas de cable no era considerada un servicio de telecomunicaciones y no estaba sujeto a reglas de no discriminación. La FCC intentó demostrar que es una prerrogativa de la agencia regulatoria la jurisdicción sobre temas no tratados expresamente en la regulación, pero comprendidos en ella en sentido lato (ancilliary jurisdiction). Para ello, expuso una serie de argumentos de derecho sobre la base de distintas secciones de la Telecommunications Act que en algún sentido lo autorizaban a supervisar cierta idoneidad y competitividad en el mercado de servicios de información.

En los hechos, la Comisión consideró adecuadamente probado a través de una serie de actuaciones presentadas por las asociaciones Free Press y Public Knowledge que Comcast enviaba reset packets –una práctica conocida como RST Injection— con la finalidad de interrumpir y terminar la conexión TCP establecida por los programas que conectados a redes p2p. Se demostró, además, que esta medida era insensible a la cantidad de ancho de banda que un usuario ocupaba o la proporción de este que ocupaba respecto de sus pares en la red local. Por ello, consideró probado que Comcast venía discriminando el tráfico p2p de sus usuarios y ello contravenía una de las Cuatro Libertades de Internet.

Sin embargo, la FCC admitió que podría estar equivocada al intentar sancionar a Comcast por discriminar el tráfico. Señaló que la existencia de una regulación explícita podría detener la innovación y por eso aplica una regla a un caso concreto (adjudication), creando un criterio decisorio que posteriormente podría revisar o terminar exigiendo legislativamente (como sucedió con el caso Carterphone). Explícitamente dijo que “las prácticas de gestión de red de los distintos ISPs llegan a ser tan distintas y especializadas en su naturaleza que resultaría imposible enmarcarlas en una regla general” (p. 19). La Comisión creía que no estaba abusando de su autoridad regulatoria, en tanto su adjudication no era del todo inesperada (si existían las Cuatro Libertades) y no estaba en contra de “la buena fe del mercado”.

De acuerdo con la FCC, no existió proporcionalidad entre las medidas tomadas por Comcast y el problema que intenta resolver: la congestión de tráfico. Así, pudo resultar afectando a usuarios que usen poco ancho de banda pero lo hagan a través de aplicaciones “desfavorecidas”, no se aplicó solamente durante los momentos del día en que hay mayor riesgo de congestión sino todo el tiempo, y no estuvo dirigida exclusivamente contra las áreas en los que existirían nodos congestionados sino al total de su planta de abonados. Para la Comisión existían soluciones más proporcionales al problema: (i) medir a los súper usuarios y cargarles un extra por el uso excesivo del ancho de banda, (ii) estrangular el ancho de banda solo de los súper usuarios, y no de la totalidad de la planta, (iii) trabajar soluciones conjuntas con los desarrolladores de las aplicaciones (ej. redes P4P). Aunque no la FCC no las patrocina expresamente, reconoce que son largamente más adecuadas a los propósitos que alega tener Comcast. Eso sí, la FCC reconoció que los ISPs tienen derecho de bloquear todo contenido ilegal (pornografía infantil, que viole derechos de autor) pero eligiendo soluciones neutrales que no alcancen a afectar tráfico legalmente cursado.

La Comisión señaló que el daño a la competencia perpetuado por las prácticas de Comcast radica en no haber transparentado sus criterios de gestión de red a sus usuarios, quienes podían pensar que las fallas en su servicio se debían a una falla de la propia aplicación y así afectar su mercado. Para la FCC, los términos de las Condiciones del Servicio que señalaban que el servicio estaba sujeto a “limitaciones de velocidad” eran demasiado vagos para el consumidor.

Como Remedio, la FCC ordenó a Comcast: (1) entregar a la Comisión toda la información referente a las prácticas de gestión de red investigadas, incluyendo los equipos que uso, cuándo y bajó que circunstancias fueron llevadas a cabo, los protocolos afectados y las zonas donde fueron implementadas; (2) enviar a la Comisión un plan de cumplimiento con puntos de referencia provisionales que describan cómo se pretende hacer la transición de las prácticas discriminatorias hacia las no discriminatorias; y (3) entregar a la Comisión y al público los detalles sobre sus prácticas de gestión de red futuras, incluyendo cualquier limitación de la forma en que sus usuarios acceden al servicio.

Reacciones

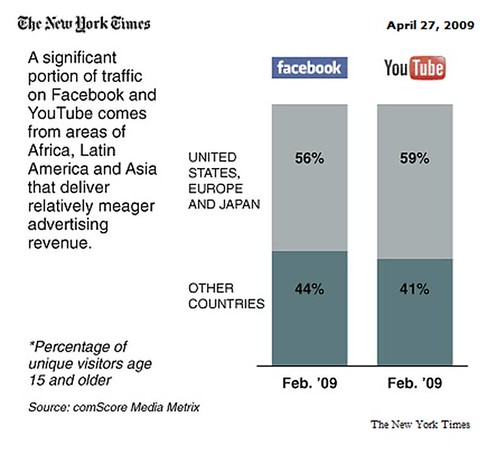

La decisión de la Comisión tuvo una respuesta mixta en los medios especializados. La EFF, aunque a favor de la Net Neutrality, vio con preocupación que la FCC pueda ampararse en la anciliary jurisdiction para imponer casi cualquier regla (como las de decencia en los contenidos). Por su parte, Wired señaló que la decisión de la FCC era una invitación abierta a filtrar Internet, al reconocer la posibilidad de que los ISPs actúen como policías y puedan filtrar cualquier tráfico considerado ilegal. Muchas empresas de telecomunicaciones, según reportó el New York Times, se mostraron de acuerdo con el fondo de la decisión pero también cuestionaron que esta regla venga a través de una decisión de la FCC y no de una ley del Congreso. Comcast, por su parte, señaló que apelaría la decisión ante la Corte de Apelaciones y, finalmente, lograría que se revoque. La historia de cómo una Corte de Apelaciones terminó diciéndole a la FCC que no tenía autoridad para exigir reglas de neutralidad de red a Comcast será el tema de la siguiente entrada de esta serie.