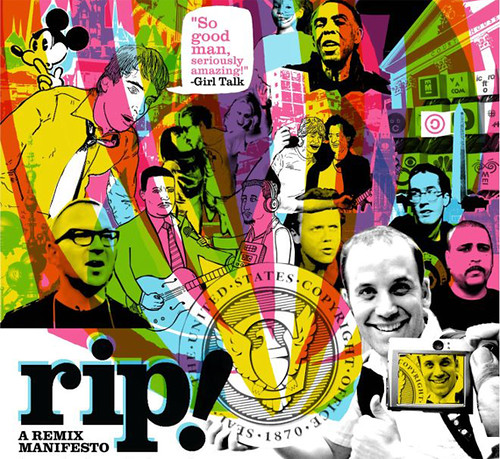

Acabo de descubrir en TED (Technology Entertainment Design), esa magnífica plataforma para la difusión del conocimiento, una conferencia de Lawrence Lessig de mayo de este año sobre derechos de autor. La conferencia, bajo el rótulo de «Reexaminando el remix» (Re-examining the remix), constituye un repaso de las posiciones de Lessig desarrolladas a partir de El Futuro de las Ideas (The Future of Ideas) y continuadas en Cultura libre (Free Culture) y Remix. Por lo mismo, la novedad no es un tópico que podrán encontrar en esta conferencia, sin embargo, no por eso deja de ser recomendable.

Lessig utiliza la dicotomía entre demócratas y republicanos para graficar la actual discusión entre creadores e industria de contenidos, contexto en el cual entiende que la libertad para crear y reutilizar contenidos es una parte esencial de la ecología cultural. Esta libertad debe permitir al mismo tiempo, el éxito comercial y la construcción de una cultura diferente. Esto último sólo se alcanza desde la construcción de una correcta definición de uso justo (fair use) que permita la innovación. Sin embargo, los derechos de autor están levantando un muro sobre la creación como realidad social integrante de la cultura pop postmoderna.

Utilizando los ejemplos de siempre (el republicano Disney como el mayor «remixeador» de la historia), Lessig cuestiona algunas posiciones conservadoras. Advierte, que si bien los republicanos incentivan la creación de un sistema de propiedad rocoso pareciera que no son tan proclives en reconocer los derechos del verdadero titular de esta propiedad. Aquí es donde aparece George Lucas, ícono de la izquierda y creador de Star Wars.

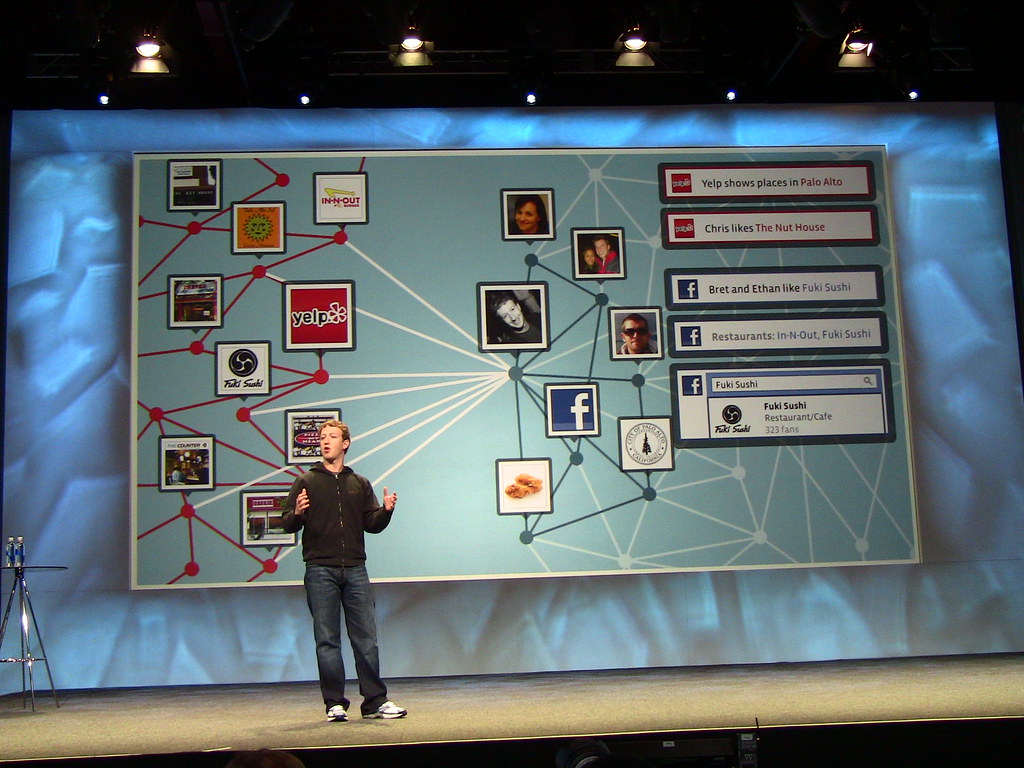

Lucas creó un sitio web llamado MashUps Star Wars (no lo he podido encontrar) donde cualquier persona podía crear episodios de Star Wars, utilizando para ello unas 250 escenas originales. Sin embargo, Lucas tiene los derechos mundiales para explotar estos mashups, a perpetuidad y sin pagar un cobre. Es decir, se priva al creador del mashup de cualquier tipo de derecho sobre su obra, convirtiéndolo en el aparcero de esta historia.

Lessig llama aparecero lo que en el Perú se conoció como yanacona. En su versión moderna el yanacona fue un elemento muy importante en el sistema de producción de la hacienda republicana. Mediante un contrato, la hacienda otorgaba al yanacona los recursos y elementos de producción necesarios, a cambio del pago de una merced conductiva, estipulada generalmente sobre una parte de la cosecha o dinero, además de la obligación de cumplir con ciertas cargas comunales. La hacienda retenía la propiedad de la tierra cultivada y el yanacona asumía la responsabilidad de la explotación (MATOS MAR, José. Yanaconaje y reforma agraria en el Perú).

La industria de contenidos parece funcionar enraizada dentro del pensamiento conservador como la hacienda republicana. Las grandes productoras son los propietarios de la tierra, de las herramientas y de gran parte de la producción del yanacona. Regresando al ejemplo de Star Wars dado por Lessig, Lucas es el propietario de las imágenes, de la herramienta y del producto del creador de los mashups, relegándolo a la función de un yanacona 2.0. Seguro que Lessig lo niega, de hecho ya lo ha hecho, pero en este extremo su análisis me parece un tanto marxista (¿Es la web 2.0 socialista? y Memorias de un pueblo fantasma, cerveza gratis y socialismo 2.0).

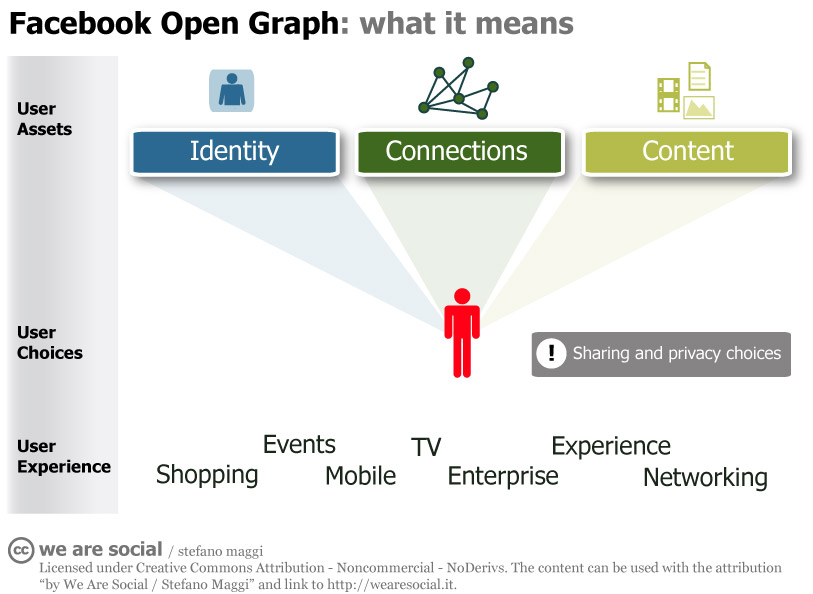

Como lecciones, Lessig señala en primer lugar, que dado que todos compartimos actividades tenemos que tener espacios protegidos de uso justo. En segundo lugar, esta ecología de compartir requiere de una libertad robusta para poder crear sin tener que pedir permiso a nadie. En tercer lugar, hay que respetar al creador de estos productos derivados y remezclados con derechos directamente ligados a ellos. Un ejemplo de una ecología de la creatividad equilibrada es el sistema de Creative Commons, propiciado por el propio Lorenzo, contrario al perverso sistema de propiedad intelectual que se viene imponiendo.

En Blawyer pueden leer algunas notas sobre las posiciones de Lessig: Tres ideas para combatir la inquisición cultural y Remix.

Les dejamos con la conferencia de Lessig, está subtitulada si se habilita la opción respectiva.

De las páginas de

De las páginas de