Interesante paper de Christopher S. Yoo (Free Speech and the Myth of the Internet as an Unintermediated Experience – La libertad de expresión y el mito de Internet como una experiencia inintermediada) sobre los intermediarios en el Internet y su posible regulación para proteger la libertad de expresión de los usuarios.

Para Yoo, cuando Internet surgió muchos elogiaron su potencial para que los ciudadanos pudieran comunicarse directamente con el público sin tener que depender de los medios de comunicación. El lenguaje de la histórica decisión de la Corte Suprema (Reno vs. ACLU) no da lugar a equívocos: “cualquier persona con una línea telefónica” puede convertirse en un “panfleto” o en un “pregonero de la ciudad con una voz que resuene más allá de lo que tendría en cualquier tribuna.”

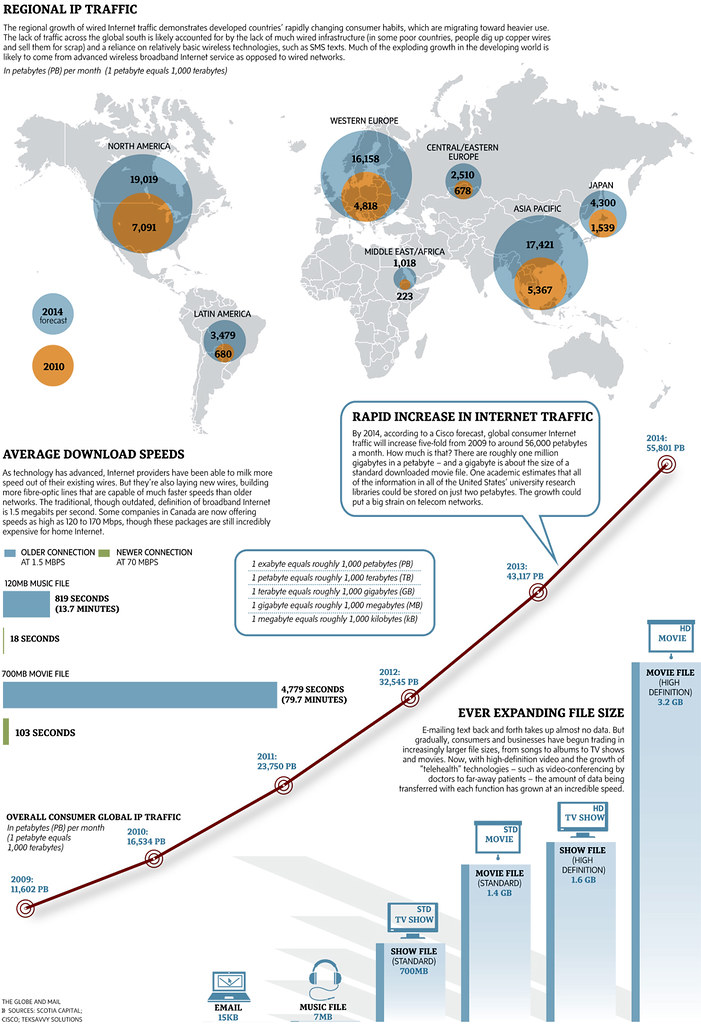

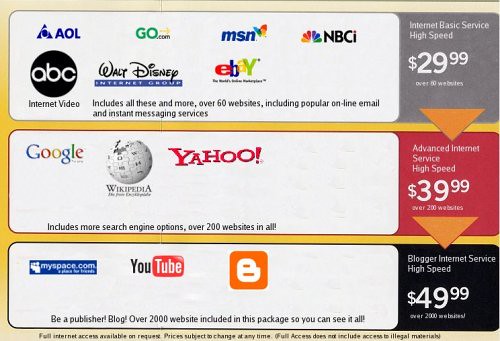

Sin embargo, en los últimos años la preocupación por el papel de los intermediarios de Internet ha ido creciendo. Inicialmente, el debate se centró en la capacidad de los proveedores de banda ancha de última milla para discriminar a favor de determinados contenidos o aplicaciones. El asunto llegó a un punto álgido cuando en el año 2008 la Comisión Federal de Comunicaciones (FCC) cuestionó las políticas de Comcast (Comcast incumplió las políticas de la FCC, pero no será multada) por ralentizar el tráfico asociado con una aplicación, aunque la decisión de la FCC fue revocada posteriormente por los tribunales (El ruido y la furia del caso Comcast 1 y 2). En este contexto, algunos académicos advierten sobre la posibilidad de que los motores de búsqueda puedan sesgar o direccionar los resultados. Tampoco faltan voces que han pedido que se ordene el libre acceso a las tecnologías de intercambio de archivos de redes sociales, como YouTube, BitTorrent, Facebook y MySpace. Más recientemente, la controversia ha surgido por el acceso a las tecnologías de dispositivos considerados clave, un ejemplo de ello es la investigación de la FCC sobre la decisión de Apple de no portar ciertas aplicaciones de voz desarrolladas por Google (F.C.C. Looking Into Rejection of Google App for iPhone).

Para Yoo estas posiciones reflejan una profunda contradicción. Por un lado se señala que es el proveedor de servicios de banda ancha, quien utilizando su poder, daña el mercado de dispositivos y aplicaciones; en otros casos, es el fabricante del dispositivo el acusado de cometer los abusos. Finalmente, sería el proveedor de aplicaciones quien estaría actuando de forma incorrecta. Como resulta lógico, estas acusaciones no pueden ser tomadas en serio al mismo tiempo. Si más de un nivel de esta cadena de distribución está dominada por un solo agente, la teoría de la doble marginalización sugiere que los consumidores estarían mejor si ambos son controlados por una sola entidad.

Numerosos estudios han comenzado a formular argumentos en contra de la intermediación en términos de la Primera Enmienda (libertad de expresión) de la Constitución de los Estados Unidos. Sin embargo, la Primera Enmienda restringe la acción del Estado y no las acciones de los actores privados. Así, bajo el entendimiento convencional de la Primera Enmienda, cualquier intento gubernamental para restringir la libertad de expresión de determinados actores privados es constitucionalmente problemático.

Diversos académicos vienen proponiendo transformar la Primera Enmienda, de una limitación negativa en la acción gubernamental a una obligación positiva del gobierno para exigir un mayor ejercicio de los derechos a la libertad de expresión. En este sentido, la Corte Suprema esbozó por un tiempo la tesis de que los organismos de radiodifusión y empresas de telecomunicaciones podían ser considerados actores estatales a efectos de la Primera Enmienda (Utils. Comm’n v. Pollak, 343 U.S. 451, 462 (1952)), aunque luego cerró esta posibilidad (Jackson v. Metro. Edison Co., 419 U.S. 345, 352–53 (1974)).

Como cuestión general, los que proponen la regulación de los intermediarios sostienen que lo importante es proteger la expresión de quienes transmiten sus contenidos y aplicaciones a través de la red. No obstante, el Internet moderno es tal vez la plataforma dominante para las comunicaciones de masas. La libertad de expresión de los medios de comunicación implica una gama más amplia de valores que incluye intereses de las audiencias, de los intermediarios, así como herramienta para la expresión de los ciudadanos.

Respecto de cómo balancear este complejo arsenal de valores, es posible explorar las decisiones de la Corte Suprema aplicables a los medios de comunicación históricos (televisión y cable). Estos precedentes han reconocido la discreción editorial y la promoción de valores importantes de la libre expresión, ayudando a la audiencia a protegerse de discursos indeseados y a identificar aquellos contenidos deseados.

Con respecto al Internet, los intermediarios ayudan a proteger a los usuarios finales contra el spam, la pornografía, los virus y otras formas de malware, mientras que permiten tamizar la avalancha cada vez mayor de contenido deseado. Así, las cortes reconocerían que la discreción editorial ejercitada por los motores de la búsqueda y los abastecedores de red implica valores importantes para la libre expresión.

La imagen del Internet como experiencia desintermediada, donde los ciudadanos hablan directamente con la audiencia sin pasar por un portero, es más un mito que realidad. La Jurisprudencia de la Primera Enmienda de la Corte Suprema de los Estados Unidos (Turner Broad. Sys., Inc. v. FCC (Turner II), 520 U.S. 180, 226–27 (1997)), se decanta a favor de la discreción editorial de los intermediarios, incluso cuando éstos simplemente sirven como el conducto para el discurso de otros.

Por otra parte, la Corte ha sostenido que el hecho de que un intermediario pueda ejercer el monopolio del poder y actuar como un censor privado no justifica que se regule su criterio editorial. Los precedentes de la Corte Suprema son agnósticos en cuanto a que el actor privado sirva de intermediario, y es muy claro que entre la censura del actor privado y el gobierno, la elección siempre debe favorecer a la primera sobre la segunda (CBS, Inc. v. Democratic Nat’l Comm., 412 U.S. 94, 124–26 (1973).